1. Přetaktování

2. Undervolting

4. Profilování

5. Paměti

6. Bottleneck

7. Monitoring

8. Download

Za poslední dekádu se dost změnilo a moderně na něj koukám jinak, než v jeho zlatý éře circa 2010. Rád nadšencům vysvětlim o čem je ten humbuk okolo týhle zajímavý disciplíny a jaký má místo v mejch sestavách. Článek Vás též zasvětí a navede do komplexního světa moderního přetaktování, zvlášť pokud chcete též začít ladit celej systém a vymáčknout ze svýho železa maximum.

O co teda jde? Je to změna hodnot nad základní specifikaci z výroby. Zní to jako španělská vesnice? Obnáší to předevšim zvýšení frekvence (zhruba čti jako výkon), napětí (kolik elektrický šťávy tam pošleš) a dalších parametrů - to všechno na jinou, než základní hodnotu z výroby, takzvanou specifikaci. Klíčový slovo je "základní", protože každej hardware jde z fabriky do světa připravenej na "to nejhorší", respektive musí mít jistou rezervu a standardizovaný parametry, aby výkon všem zákazníkům odpovídal slibům specifikace. Právě tady nastává krása přetaktování – overclockeři tomu řikaj silicon lottery. Výroba křemíkovejch čipů je neskutečně komplexní věc, kdy dnešní tranzistory – fancy spínače z polovodiče křemíku, který nám počítaj jedničky a nuly – měříme v nanometrech. Jsou opravdu prťavý a při výrobě je velká různorodost kvality a šance defektů. Proto každej kousek kterej nám vyjede z fabriky, je trochu jinak povedenej a taky skrejvá různej potenciál. A to ne jen v maximálnim dosaženym taktu, ale i právě v efektivitě základních taktů a poměru napětí vůči frekvenci v celym spektru, o čemž se moc nemluví.

Zvýšení výkonu jednoduchym naklikánim vyšších hodnot zní fajn, ne?

Běžný přetaktování už ale taky neni to, co dávno bejvalo a rozhodně neni tak přímočarý a jednoduchý. Nedá se z něho těžit tolik hrubě využitelnýho výkonu, většinou to je už pod 10%. Výrobci si dneska už chytřeji segmentujou trh a automatizujou boostování frekvencí podle způsobu využití. Já ve svejch sestavách ze součástek nikdy nemačkám maximum, protože pro dlouhodobý používání to nemá už dneska z mýho pohledu praktickej smysl. U stropu schopností každýho čipu se totiž energetický ztráty zvyšujou exponenciálně. Vždy tedy hledám tuhle hranici, kde nastává zákon snižujících se výnosů (diminishing returns), kdy za každej hertz navíc platíte neúměrně vyšším napětím. S tim příchází vyšší spotřeba, s tou zas vyšší teploty, ty zvyšujou nároky na chlazení, tedy i hluk a při špatnym nastavení eventuálně horší stabilita nebo funkčnost. Vznikaj tu tedy opravněný obavy o životnost čipů a i proto tolik vyzdvihuju důležitost chladičů, ventilátorů, účinnosti zdrojů, napájecích kaskád a jejich nastavení, který jsou samozřejmě neméně podstatný i u běhu počítače na jeho základních parametrech.

Taktuje se předevšim grafická karta (a její paměti VRAM), procesor a taky paměti RAM (bohužel často zapomenutý). Princip je vcelku blízkej tomu, když si chcete "načipovat" řídící jednotku motoru v autě. Konzervativnější nastavení z výroby jde více či méně upravovat podle využití potenciálu konkrétního aparátu. V závislosti na tom jak se bere ohled na zbytek systému auta, to potom může skončit velmi výhodnym zvýšenim výkonu, vyladěnim z výroby přiškrcený křivky krouťáku, následný zvýšení efektivity spalování nebo dokonce snížení spotřeby. A nebo se to taky dá úplně pokonit. Záleží, kdo na to šáhne.

S každou novou architekturou / generací příjdou v podstatě nový pravidla pro přetaktování, zvlášť když si všechny moderní čipy řídej paramety složitou automatikou několikrát za sekundu. Vzhledem k tomu, že z výrobní linky padaj různě povedený kousky čipů pro stejnej produkt, výrobce nemá čas ani podnět pro to každej kus individuálně testovat a prodávat podle kvality silicon lottery. Řeší to tak, že všem procesorům skrz mikrokód BIOSu nastaví takzvaný VID (identifikátor napětí), což je to hodnota napětí, na kterou v podstatě každej čip z konkrétní řady, kterej kdy vyjel z výrobní linky a prošel základnim testem funkčnosti, spolehlivě rozjede určitou frekvenci. Je to takovej standard, kterym výrobce zaručí stabilitu a kompatibilitu každýho kousku na trhu. Ten stejnej standard musí taky zaručit výrobce desky / karty, proto kvalita napájecí kaskády desky nebo grafiky dává další prostor pro dosažení lepších výsledků. Tady nastupuje můj individuální přístup, kdy až já si s hotovou sestavou můžu dovolit tyhle parametry přesně donastavit a hledat, jak velkej potenciál konkétní kus skrejvá. Jak asi spousta ví, tohle je naprosto běžná povaha všech produktů z výroby a vzhledem k rychlosti produkce spotřebního zboží tohle nejde plošně řešit s tim, že každej kousek komplexního křemíku má různý elektrický vlastnosti a od výroby je nutný naddimenzovaný napájení.

Je tady proto spousta způsobů, jak se k taktování postavit a jak systém ladit (tweaking). Někdo to dělá jako vášeň, hobby, pořádaj se v tom velký akce, dokonce mistrovství. Spousta lidí v něm taky bohužel vidí prostě a jenom výkon navíc zdarma a snažej se z křemíku vymáčknout co to jde, takže hledaj tu nejjednodušší cestu, nejvyšší možnou hranici, kterou jim čip povolí, zvyšujou napětí dokud systém nepadá, hodí na to gigantickýho hlučnýho vodníka a maj z toho dobrej pocit. Tyhle praktiky ale podle mýho nepatřej do běžný mašiny a tuhle disciplínu to rozhodně nezpopularizuje, proto se snažim dostat někam do středu, kdy z toho benefituju já i zákazník a chci aby ladění mělo praktickou hodnotu. Vzhledem k tomu, že z prostýho přetaktování se už dneska nedá dostat třetina, někdy i polovina výkonu navíc jako dávno, tak ani nemá cenu mačkat z křemíku co to jde. Bohužel zlatý časy, kdy se s levnym Core 2 Duem člověk mohl dostat na výkon dvojnásobně dražšího modelu jsou už pryč a kvůli nastavení trhu se už pravděpodobně nikdy nevrátěj.

U taktování proto obecně vidim novodobě jinej přístup, jeho odnoš, která zatim neni moc popularizovaná, zato si myslim že mnohem víc funkčně přínosná, kdy za kousek času přínáší jenom výhody - takzvanej undervolting.

Zatimco u přetaktování je klíčová přípona pře, která napovídá, že se bude navyšovat frekvence i napětí přes základní hranici, tak undervolting, neboli podpětí, nechává frekvenci většinou podle specifikace, ale snižuje napětí předevšim za účelem snížení spotřeby při zachování výkonu. Individuální kvalita křemíku v rámci loterie totiž nediktuje jen maximální dosažitelnou frekvenci při určitym napětí, ale taky poměr frekvence / napětí na celý F/V křivce. Undervolting kromě snížení spotřeby a teplot dál omezí zátěž na napájecí kaskádu, bzučení cívek a samozřejmě zbytkový teplo celýho subsystému. Tam samozřejmě vzniká příležitost dál regulovat ventilátory pro nižší hluk a celkově příjemnější chod celku. Pro někoho tedy až možná překvapivě řečeno - když na to jdete dobře, životnost hardwaru můžete paradoxně zvýšit změnou parametrů mimo tovární specifikaci. Společně s tim když je majitel obeznámenej o změnách ve svym stroji a občas pro zvědavost sleduje teploty a životní funkce celku, vytváří to větší spříznění a povědomí o tom, jak mu komp funguje.

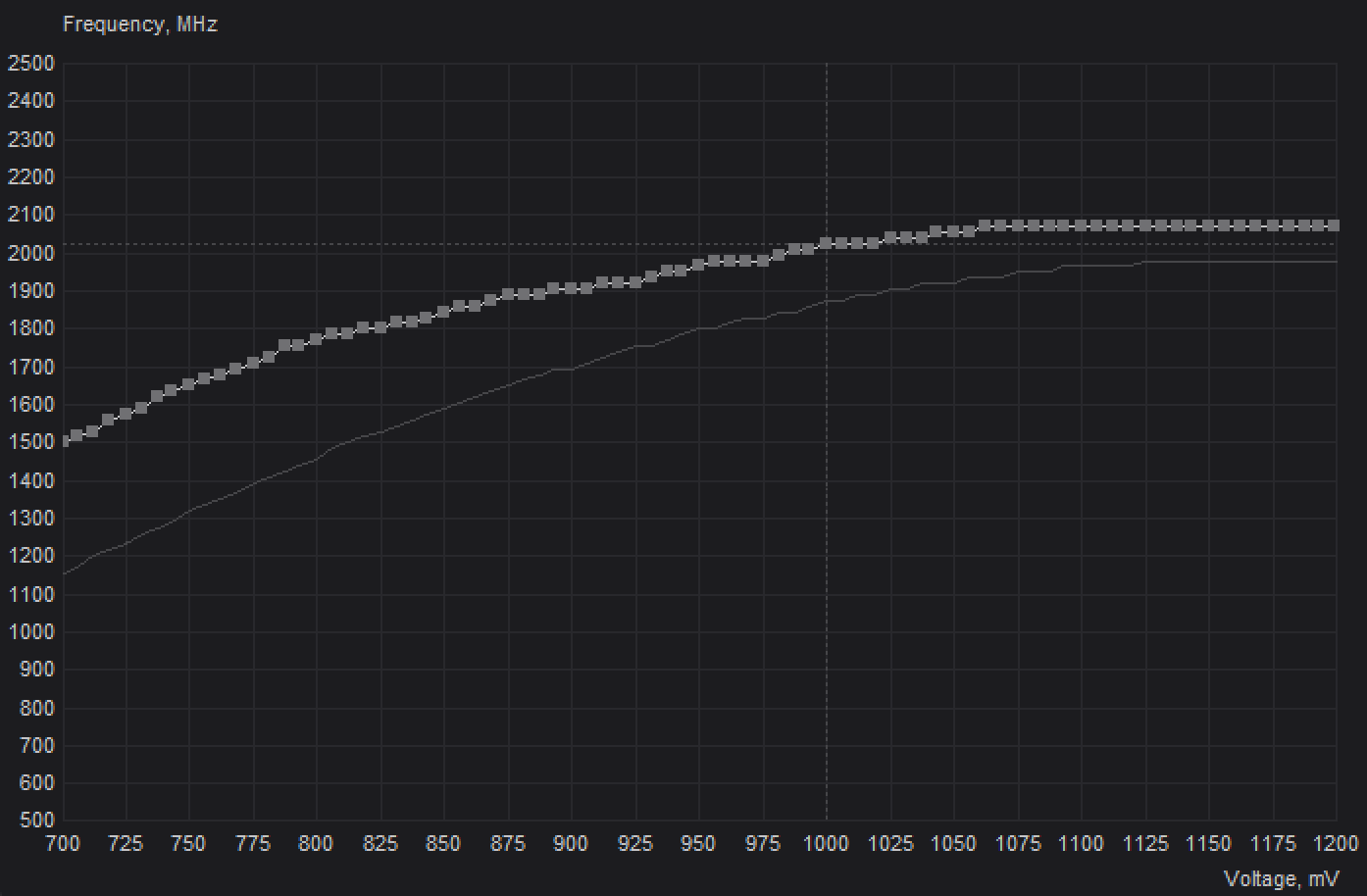

Pro příklad přikládám graf z mýho měření u procesoru a grafický karty při hraní, kde jde vizuálně vyčíst, jak velká je běžně rezerva u undervoltingu / overclockingu oproti továrnímu nastavení a jak vcelku běžně vypadá charakteristika po mym ladění. Taky je vidět jak neúměrně na výkonu roste spotřeba a jak při ladění v tomhle rozsahu frekvence člověk nepřichází o tolik výkonu při výraznym snížení spotřeby. Po měření a zátěžovejch testech najdu vhodnej bod, kde křivku zakotvit, nastavim napětí, frekvenci, limity, na základě toho můžu dál snížit hluk a zmírnit křivku ventilátorů. Pro každou soušástku potom vytvořim profily, u grafický karty dokonce na různejch výkonnostních úrovních pro vyšší flexibilitu.

Spotřebu – na kterou je zbytek provozních vlastností závislejch – běžně snížim u procesoru okolo čtvrtiny a až o třetinu u grafický karty při továrnim výkonu. Případně výkon navýšim o až 10% při lehkym snížení až zachování spotřeby. Naopak zase při lehkym ponížení výkonu o cca 10% a zaření dalších limitů se někdy dá dostat až poloviční spotřeba a proto dělám i extra úspornej profil. Garantovaně to ale bude v každý úrovni vždy poměrově lepší, než výchozí nastavení od výrobce nebo v běžně dostupnejch sestavách a to s výhodou vyšší životnosti. Společně s pořádnym zdrojem a napájecí kaskádou s vysokou účinností mám proto běžně ve výsledku o 50-150W úspornější komp v zátěži, než v základnim nastavení nebo u jinejch kompů s identickym výkonem. Každá další drobná optimalizace efektivity v sestavě se sčítá a jsem tak trochu pedant na co nejvyšší elektrickou účinnost :)

Boostování, limity a frekvenční křivky jsou kromě segmentace trhu další důvod, proč je přetaktování dneska tak jiný, než bylo třeba v roce 2010. Je to často přehlížený téma, který pro laiky komplikuje porozumění mechanismů přetaktování a proč už se dneska nedá výkon zvedat tolik jako dřív. V podstatě všechny moderní procesory a grafický karty jedou na dynamice jejich limitů a složitýho, neustále přítomnýho řízení všech parametrů složitou automatikou. Jde předevšim o limity spotřeby, teplotní, napěťový, proudový a pár dalších podle kterejch čip několikrát za sekundu reguluje frekvenci a napětí, tim i výkon a chování ventilátorů. Jsou hlídaný skrz senzory v počítači, který křemíku řikaj, jak se chovat v závislosti na aplikaci, hře, jejich instrukcích, využití technologií, vytížení částí čipu, na kvalitě chlazení a napájení. Má to spoustu výhod z hlediska ochrany čipu, ukočírování tepla a optimalizace spotřeby. Když to je vhodný, zamezujou kriticky vysokýmu proudu / teplotám při zatížení všech jader, když tak vysoká frekvence ani neni potřeba a zase naopak pomáhaj výraznýmu chvilkovýmu navýšení výkonu na jedno jádro, když si počítač ve zlomcích vteřin řekne o rychlej výkon při nahodilym nebo jednovláknovym vytížení, takzvaný boostování.

Žádný moderní CPU nebo GPU tedy nejede na pevnejch frekvencích, jak tomu bejvalo dřív, kdy u přetaktování stačilo zadat jednu frekvenci při jednom napětí, tu otestovat na stabilitu a měli jste hotovo. Dnes když například procesor zaznamená, že používáte všechny jádra na export videa a editor při renderování narazí na limit spotřeby, při takhle náročnym úkonu srazí frekvenci jader klidně o několik stovek, i tisíc MHz, aby se vešel do okna power limitu (nejspíš nejčastější limit, na kterej v praxi jádra naráží). Pokud si ale pustíte třeba Counter Strike nebo jednodušší hru, kde se vytěžuje jenom pár jader a grafickou kartu často jen zčásti, automatika Vám povolí frekvenci zvýšit na maximální boostovací frekvenci, pokud se vejde do všech limitů. V každym případě Vám frekvence bude lítat furt tu a tam na CPU i GPU a každá zátež (workload) poměrově vytíží jádra u každý aplikace úplně jinak a pokud narazí na nějakej limit, frekvence bude automatikou upravená někde mezi základní frekvenci (base clock) a boostovací frekvenci (maximum boost clock). Base clock je často minimální deklarovaná udržitelná frekvence v zátěži, zatímco maximum boost clock je maximální povolená frekvence, která poběží paradoxně jen při lehčí zátěži, často jen na zlomku jader. Například procesor AMD Ryzen 9 9950X má podle specifikace tyto frekvence v rozmezí 4,3GHz - 5,7GHz a dokonce pro každý jednotlivý jádro ze svejch 16 jader upraví frekvenci zvlášť do limitu 170W. Nevytížený jádra se dokonce můžou úplně vypnout, nebo jet na mnohem menší frekvenci, než je base clock (třeba 0,8GHz při procházení webu, sledování videa). Grafická karta Vám zase pojede na vyšších frekvencích pravděpodobně jen ve hře nebo grafickejch aplikacích, dokonce ani u přehrávání 4K videa se moc nezapotí a stáhne si frekvenci hluboko pod svojí základní frekvenci.

Znalost limitů je tedy velmi důležitá a nově u overclockerů řekl bych často přehlížená. Člověk si pak může trhat vlasy nad náladovym chování a crashování svýho kompu. Při týhle náročný hře a renderování mi to jede bez problémů, ale pak najednou při běžnym procházení webu dostanu error nebo modrou obrazovku smrti? (BSOD - Blue Screen of Death). I to se může stát. Tahle dynamika samozřejmě komplikuje každej uživatelskej zásah při ladění. Stabilitu CPU a GPU po ladění je tedy důležitý testovat na celym spektru poměru frekvence / napětí v různejch aplikacích. Tohle spektrum se dá vágně nazvat jako F/V křivka (frekvence / voltáž) a každej výrobce má specifickou sadu nástrojů s způsobů, jak moc uživatelům dovolej se v týhle křivce a limitech hrabat.

V grafu je názorně zobrazená křivka GPU GeForce RTX 3070. Slabě je značená křivka z výroby a silně je moje vlastní upravená křivka po undervoltingu / overclockingu, kde je v bodech nastavená každá hodnota napětí pro určitou frekvenci. Podle nastavenýho spotřebovýho power limitu pak automatika při zátěži určí, na jakym bodě jádro pojede, aby se celek vešel do nastaný wattáže. Z výroby běžně grafika mění tuhle hodnotu několikrát za sekundu, aby se vešla podle aktuální zátěže do power limitu, u mejch balanced a silent profilů ale nejvyšší bod vždycky zakotvim tak, aby byla frekvence stabilní po celou dobu běžnýho hraní. U mýho nejvyššího "overclock" profilu je křivka odemknutá celá, ale i přes to se na ní dá využít výhod undervoltingu v plnym rozsahu, klidně i s poloviční spotřebou – jednoduše se nastaví power limit chtěný výše spotřeby a automatika si řídí frekvence a voltáž podle zátěže na mnohem vyššim stupni výkonu, než v základu. Na přiloženym grafu je například vidět, že i při omezený spotřebě konkrétní kousek dosahuje frekvence přes 2GHz (kříž šrafovanou čarou), kterou by běžně v základu nedosáhl ani bez limitů. Taky je vidět zlepšenej náklon křivky, kterýho jsem schopnej dosáhnout jen testováním více bodů křivky při fixním napětí, kdy nižší stavy výkonu maj poměrově mnohem vyšší efektivitu a dosahujou nadprůměrně vyšších frekvencí. V tomhle případně je u nižší části křivky výkon často škálovatelnej až o 20%. Tenhle náklon je u každýho kousku jinej, ale většinou se daří dostat tuhle charakteristiku právě na výběrovějších kouscích čipů dražších edicí karet s kvalitní napájecí kaskádou. Podobně vypadá i křivka u CPU, ta ale většinou neni takto přehledně znázorněná kvůli grafickýmu omezení BIOSu, kde se právě chování F/V ladí (např. funkce AMD Precision Boost Overdrive a Curve Optimizer), zatímco u GPU se běžně ladí se zaplym systémem ve Windowsu ve speciálních aplikacích (např. MSI Afterburner na následujícím grafu).

Všechny zde uvedený praktiky kombinuju v závislosti na možnostech konkrétní sestavy a každej kus je vždy jinej. S mojí sestavou chci dát každýmu svobodu výběru na jaký úrovni taktování se chce zrovna držet. Každej celek posílám do světa s uváženim jak poměr overclockingu a undervoltingu sedí na konkrétní model, chlazení, zbytek systému a preference zákazníka. Všechny individuální nastavení včetně termoregulace ventilátorů ukládám pevně v BIOSu, případně MSI Afterburneru, kde má potom uživatel uložený profily všech úprav a může si je v rámci několika sekund přepnout a to i při zatížení grafiky, například ve hře.

profil #1 suprsilent cca 90% výkonu s velmi výrazně nižší spotřebou, hlukem a teplotama

profil #2 balanc 100% továrního výkonu s undervoltingem při nižších teplotách, hluku a spotřebě

profil #3 overclock 105-110% výkonu bez zvýšení napětí, hluk podobnej jako v továrnim nastavení

V základu vždycky nastavuju svůj prostřední, vybalancovanej undervolting profil, kterej výkonově odpovídá tomu v továrnim nastavení, ale těží výhody ve všech ostatních oblastech. K tomu mám nižší a vyšší profil. Každej si tedy může přeladit podle uvážení, svýho ucha a potřeby výkonu. Rozdíl ve výkonu profilů bejvá okem málo postřehnutelnej, zato hluk a spotřeba už bejvaj znatelný. Každej profil je poměrově výrazně efektivnější, než ten v továrnim nastavení, jelikož F/V křivka je vždycky posunutá na svůj maximální potenciál při určitym stupni výkonu pro konkrétní kus.

Tohle je pro mě blízký téma a úrodná půda pro navyšování neobjevenýho výkonu, protože se běžně u testování a přetaktování RAMky skoro nikdy neřešej a jsou furt trochu pozapomenutý. Za to může určitě dlouholetá mantra, že rychlost operačních pamětí neni moc důležitá a u přetaktování je to zas vysoká časová náročnost (a frustrace :) pro optimalizaci takzvanýho časování. Proto je přetaktování pamětí záležitost spíš pro fajnšmekry, který chtěj z výkonu vytáhnout maximum a nabízim jí jen jako doplňkovou službu. I na rychlost RAM je ale citlivá naprostá většina dnešních náročnejch aplikací, zvlášť těch citlivejch na odezvu, k čemu mimo jiný patřej právě hry. Když chcete vytáhnout z procesoru maximum výkonu a dál už to nejde, můžete se spolehnout, že RAM je další součástka, která Vám to povolí. Výkon procesoru je totiž s RAM neodmyslitelně svázanej, stejně jako grafickej čip GPU s jeho pamětí VRAM. Proto kdekoliv kde jste omezený procesorem (CPU bound / bottleneck) a čim víc hrajete hry na vysokejch FPS, tim víc je rychlost RAM důležitá pro získání dalšího výkonu (příkladem se tomu věnuju v materiálu o bottlenecku). Vlastně výkon na pamětech vždycky byl závislej, jen jsme to: a) neuměli změřit, b) zbytek hardwaru na trhu nám to neumožnil tolik vidět, c) jsme nebyli tolik náročný jako dneska, případně to nebylo tak důležitý. S dnešníma mohutnejma grafikama, megajádrovejma procesorama a náročností softwaru se jejich důležitost dostává do popředí.

U grafickejch pamětí VRAM nám výrobci zatim nedávaj tak velkou volnost, nemůžeme se hrabat v časování, snižovat frekvenci nebo napětí, jde akorát navyšovat frekvence při fixním napětí, takže tu jde hodně o křemíkovou loterii. I tady se dá ale nabrat pěknejch pár procent výkonu jen při drobnym zvýšení celkový spotřeby a proto když má karta dobře řešenej systém chlazení VRAM, je tady skoro škoda nepřidat.

Jak jste asi už poeticky slyšeli, počítač je jen tak rychlej jako jeho nejpomalejší součástka. V minulosti jsme nezažívali tak velký nárůsty výkonu procesorů, masivní nárůsty byly ale u grafickejch karet. Ty vždycky nejvíc brzdily hry, protože to je prostě podstata grafickýho akcelerátoru - bere si tam nejvíc práce a je to hlavní tahoun. V náročnejch hrách jsme potom byli rádi, když jsme se dostali přes 50FPS a procesory i RAMky na tyhle frekvence naprosto stačily. Dneska už máme ale grafiky tak výkonný, gigantický, drahý a žravý, jako třeba až 400W modely RTX 3080, který udělaj i ve vyššim nastavení stovky FPS, že ten limit co brzdí FPS nemusí bejt grafika, ale klidně i procesor, nebo třeba RAMka. V takovym případě seberychlejší grafika FPS nezvedne a pokud chceme tahat další výkon, musíme koukat dál na CPU+RAM. Jako tenhle "bottleneck" si můžeme třeba v případě CPU představit trychtýř, kdy grafika seshora sype procesoru snímky, ale když neni šířka trubice procesoru dostatečně široká, průtok se přiškrtí, výkon celku se omezí na úroveň toho, co teče do dolní nádoby a grafika nedokáže dávkovat snímky na maximum svýho potenciálu. V tomhle scénáři tomu řikáme CPU bottleneck, tedy když procesor omezuje výkon celku a nejspíš ten nejčastější příklad problémů s nepravidelnym trhánim plynulosti v praxi.

Takovej novej Tomb Raider, Assassin's Creed, Battlefield nebo Red Dead Redemption si uměj už slušně sáhnout i do vícevláknovýho výkonu CPU a tam kde dřív základní 4 jádrový Intely drtily AMDčka s 8 jádry / 16 vláknama, to už v těhle hrách neni ani zdaleka pravda. Je to případ, kdy nestačí multijádrovej / vláknovej výkon procesoru, kterej jede na 100% a způsobuje mnohem větší, nepravidelný trhání, než když by bottleneck způsoboval nedostatečnej výkon grafiky, případně jednovláknovej výkon nedostatečně vytíženýho procesoru. Před deseti lety proto bohatě stačily dvoujádrový procesory a 800MHz RAM na naprostou většinu využití, i když už byly v nabídce šestijádra a 2400MHz RAMky a v testech se ten rozdíl moc nebo vůbec neprojevil. Tenkrát taky nikdo neřešil 80 versus 120 FPS protože to monitory neuměly zobrazit, naprostá většina obrazovek jela na 60Hz.

Proto způsob, jakym se koncipujou testy a jak si poraděj s bottleneckem, je sakra důležitý. Dneska už jsou mnozí recenzenti metodičtější a začíná se objevovat spousta nezávislejch nadšenců, který maj pro každej detail plno vášně (kupříkladu Gamers Nexus na YouTube). Dřív byly testy a benchmarky dost prostý a spoustu věcí se za tu dobu změnilo. Třeba už tenkrát na prvnim Crysis (2007) jsem teoretizoval jak testoval přínos rychlejších RAM v budoucnu. Stačilo snižit rozlišení třeba na mini 800×600 a detaily na nejnižší, tim tehdejší grafiky shodily většinu zátěže a pak už jen stačilo měřit, jakej teoretickej framerate by dokázalo Core 2 Duo nahnat oproti staršímu Athlonu X2 a jak moc skok z 800MHz RAM na 1066MHz sníží bottleneck paměti. Samozřejmě, s výkonym HW tenkrát nikdo nechtěl hrát na tohle nízký nastavení, všichni řešili grafickou kartu, který tenkrát byly oproti dnešku superslabý. Ukázalo to ale jasnou věc - kolik FPS z toho vytáhne procesor / paměť, až budou v budoucnu grafiky mnohem výkonnější a nebude ve hře GPU bottleneck. Testy totiž tenkrát přínos dražších procesorů moc ukázat nedokázaly právě kvůli bottlenecku grafiky. Obecně - když snížíte zátěž na grafiku, přesune se zátěž na CPU, která je úzce spojená s RAM. Crysis tenkrát neumělo využít víc než dvě jádra / vlákna (i dnešní nejlepší Intely v Crysis v určitejch pasážích nejsou schopný vykouzlit víc než 50FPS), ale to byl prostě limit toho, jak hra byla napsaná. Proto si na něm možná tak změříte jednovláknovej výkon jednoho jádra. V dnešní době se už ale většina her píše pro moderní API DirectX 12 a VULKAN, který dokážou každou část systému využívat mnohem dynamičtěji a proto začíná bejt téma bottlenecků stále důležitější.

Pro úspěšný ladění je samozřejmě potřeba sledovat senzory hardwaru. Těch je v počítačů celá hromada a ty zásadní Vám napovědi jak systém ladit. MSI Afterburner (a jeho společník RivaTuner Statistics Server) je nejspíš ta nejužitečnější aplikace pro přetaktování grafickejch karet, monitoring a vše s tim spojený. Je široce kompatibilní a funkční klidně na železe z přelomu milénia s Windows XP. Z mýho měření nežere na modernim hardwaru ani watt nebo FPS navíc, naopak se správnym zacházenim Vám může elektřinu ušetřit, nebo zase FPS zvýšit. Používám ho na undervolting grafiky, profilování, ladění ventilátorů a diagnostiku chování PC. Přínos Afterburneru pro Vás je taky ten, že si skrz něj můžete měřit FPS ve hře (frekvence snímků za sekundu, křivka plynulosti “frametimes”) a k tomu ukazuje ty zásadní senzory v počítači, kterejm nejspíš budete i jako laik rozumět. To vše v přehledný překryvný tabulce “OSD”, kterou jsem upravil pro lepší přehlednost. Vzhled a funkce Afterburneru jdou do obrovskýho detailu přizpůsobovat, nicméně v základu je nastavení zbytečně nepřehledný, OSD neni vůbec nastavený ani aktivovaný a ovládání je vcelku ošemetný. Proto ho každýmu dolaďuju pro vyšší uživatelskej komfort a moje nastavení (na screenshotu) jde vždycky stáhnout na webu pro všechny. Pro grafiku (zeleně) a procesor (modře) ukazuje odděleně jejich vytížení, frekvence, teploty, spotřebu, zaplnění paměti a další. Pokud Vám monitorování nějakýho senzoru chybí, je možný, že aktuální verze Afterburneru (zatím) konkrétní senzor (zvlášť na novějším hardwaru) nepodporuje. V takovym případě může pomoct HWiNFO.

Kdo zná tenhle pohled? :)

Zde odkážu na stáhnutí potřebnejch nástrojů pro kompletní vybavení overclockera.

Pro monitoring jako první doporučim výše zmíněnej MSI Afterburner.

Nemusíte mít MSI hardware pro jeho využití, má širokou podporu.

Instaluju ho do každýho svýho kompu, ke kterýmu taky tisknu průvodní leták, kterej výhody a ovládání Afterburneru stručně popisuje, případně mám onen leták zde ke stažení.

Rád taky vysdílím soubor s mym nastavením Afterburneru pro všechny, kdo by měli zájem (případně o něj přišli), protože ve výchozím nastavení chce ještě hodně práce, aby byl přínosnej a pohodlnej používat - pro mě použitelný nastavování je klidně práce na hodiny (například vytvořit přehledný HUD). Přenesení nastavení je jednoduchý:

· Stáhněte, rozbalte a nainstalujte Afterburner ze stránek MSI.

· S nim se společně nainstaluje i RivaTuner, kterej obstarává HUD, měření FPS a dalších funkcí.

· Aplikace zatim nezapínejte, případně je vypněte.

· Přesuňte obsah do složek instalací, defaultně do C:\Program Files (x86), soubory přepište.

· Afterburner zapněte, od teď se bude schovávat dole vpravo v liště pod ikonou letadýlka se startem Windows.

· Zkuste libovolnou hru zda se v ní ukáže HUD. Pokud vidíte tabulku výše, vše se aplikovalo. Klávesa "Insert" jí přepíná.

· Všechno nastavení, hotkey klávesy, funkce a senzory se daj dál přizpůsobit v nastavení Afterburneru.

Upozornění: soubory s nastavením neobsahujou ladění specifický pro konkrétní hardware - tedy cokoliv co se týká přetaktování, termoregulace ventilátorů, změny napětí, křivky frekvence, stavů výkonu, nastavení limitů pro spotřebu a dalších si prostě a jednoduše "nestáhnete". To obnáší znalost problematiky přetaktování a další hodiny důkladnýho testování pro získání benefitů všech používanejch praktik při zajištěný stabilitě ve všech využitích. Na internetu je spousta návodů, komunit, který přetaktování / undervolting řešej - spoustu dobrejch, ale i špatnejch. Ačkoliv je použití Afterburneru víceméně bezpečný a každá karta má do jistý míry nastavený limity regulace a teplot, pokud si nechcete zadělat na další hobby, tak se změnou hodnot netrapte :)

Při potřebě ještě detailnějšího přehledu senzorů v kompu doporučim zase HWiNFO, drobná utilita od šikovnýho Slováka, která má podle mýho pozorování nejširší podporu, nejpřesnější měření a umí přečíst nejvíc senzorů. Grafickej interface je hrozně základní, ale jeho jednoduchost může bejt preferovaná. Jde taky propojit s Afterburnerem, kterej může číst jeho extra senzory, pokud ve free verzi v nastavení aktivujete "podporu sdílené paměti". Moje zde stáhnutelný nastavení Afterburneru má základní plug-in propojení s HWiNFO vyřešený a v základu ukazuje pár senzorů navíc - otáčky ventilátoru a napětí CPU, frekvence RAM a další. V závislosti na kombinaci hardwaru je ale občas plug-in potřeba donastavit pro zobrazování určitejch senzorů.

Při potřebě zatěžování systému syntetickejma (umělejma) testama odkážu na prime95 pro procesor / RAM a FurMark pro grafickou kartu / VRAM. Tady ale upozornim na fakt, že vzhledem k jejich vysoký umělý náročnosti je jejich správný použití komplikovanější a potřebuje širší kontext se znalostí elektrickejch limitů Vašeho hardwaru. Obě aplikace totiž narazej na limity spotřeby Vašeho CPU / GPU / napájecí kaskády, protože na ně pošlou zátěž, která neni při běžná v reálnym využití a čipy shoděj frekvenci víc, než je běžný. Tyhle dvě aplikace jsou skvělý doplňky na různý využití jako okamžitý vymáčknutí maximální spotřeby, testování chlazení, chování boostovacího algoritmu, ale zároveň Vám pravděpodobně nikdy nepojedou na nejvyšších frekvencích / voltážích, proto se na nich těžko testuje stabilita špičkovejch frekvencí. Trochu uživatelsky přívětivější a flexibilnější je OCCT.

Pro ověření přínosu úspěšnýho přetaktování nebo při jakymkoliv hejbání s parametrama je potřeba ověřit výkon a stabilitu kvalitníma benchmarkama - herní, syntetický i ty s reálnym využitím. Je to z důvodu výše zmíněný dynamiky boostování, limitů a složitýho, neustále přítomnýho řízení spousty parametrů automatikou. Ta komplikuje každej uživatelskej zásah, proto důrazně doporučim všechno přetestovávat s využitím všech výše zmíněnejch nástrojů a skutečnej nárůst výkonu ověřit konzistentnim benchmarkem a měřením FPS ve hře, protože Vás potom může překvapit nahodilá nestabilita systému časem v aplikaci, kterou jste předtím nepoužívali. Dobrej syntetickej základ je Cinebench na procesor a 3DMark na grafiku (případně RAM i VRAM). Dále běžně používáný real-life aplikace, editory a hry s ohledem na jejich bottlenecky a limity. Například Cyberpunk 2077 bude ještě dlouho dávat zabrat jak grafice, tak procesoru a je velmi vhodnej na testování. Jakákoliv jiná novější náročná hra ale taky odvede svojí práci, pokud ji správně nastavíte podle senzorů tak, aby narážela na limity a bottlenecky - stabilitu a výkon je potřeba testovat na vysokejch rozlišeních pro grafickou kartu, zatimco procesory je třeba testovat na nízkejch rozlišeních pro eliminaci GPU bottlenecku a maximálního vytížení CPU.